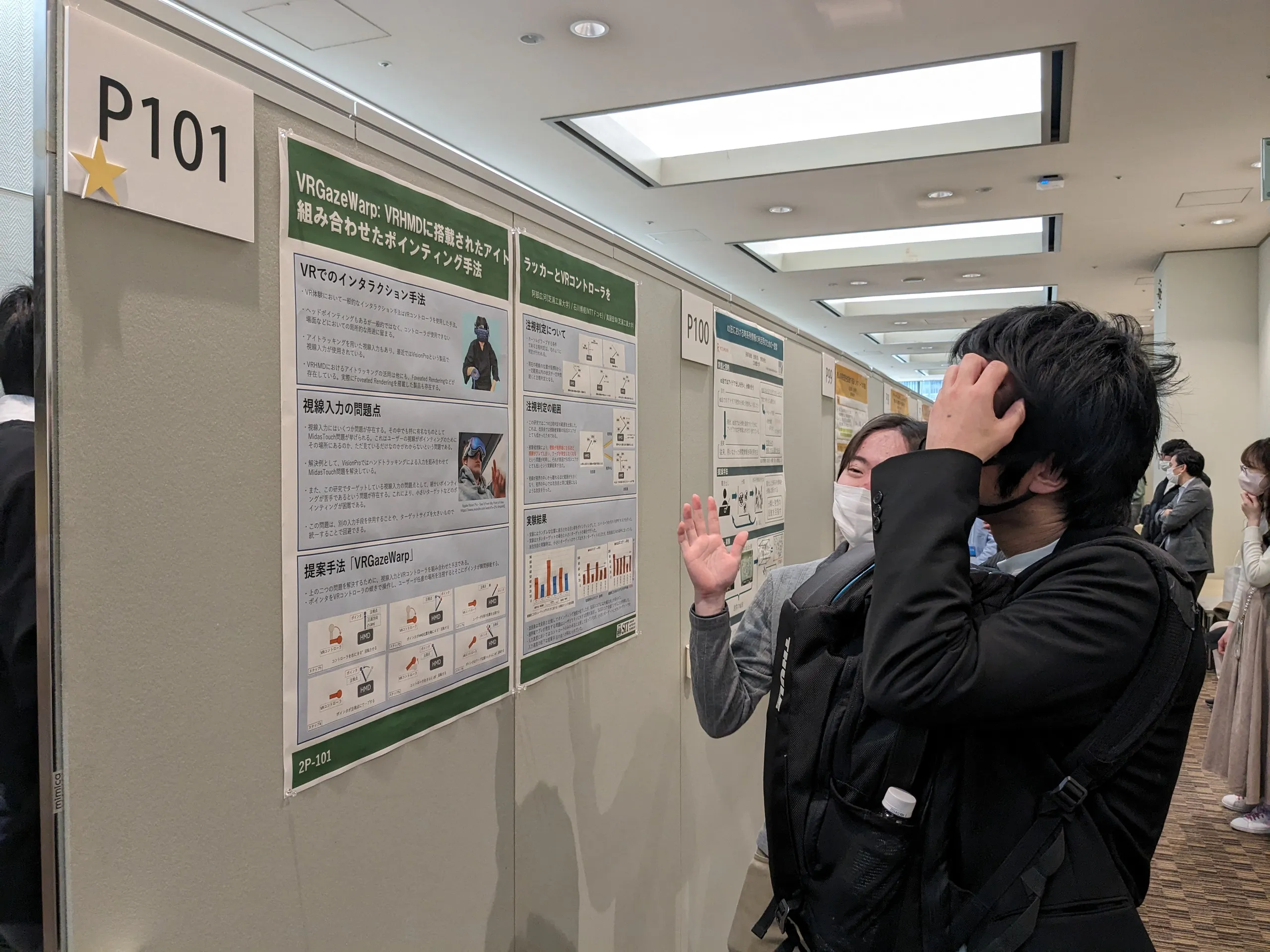

インタラクション2024にてポスター発表・デモ発表を行いました(M2阿部広河・M1下田・B4國枝・B4武田)

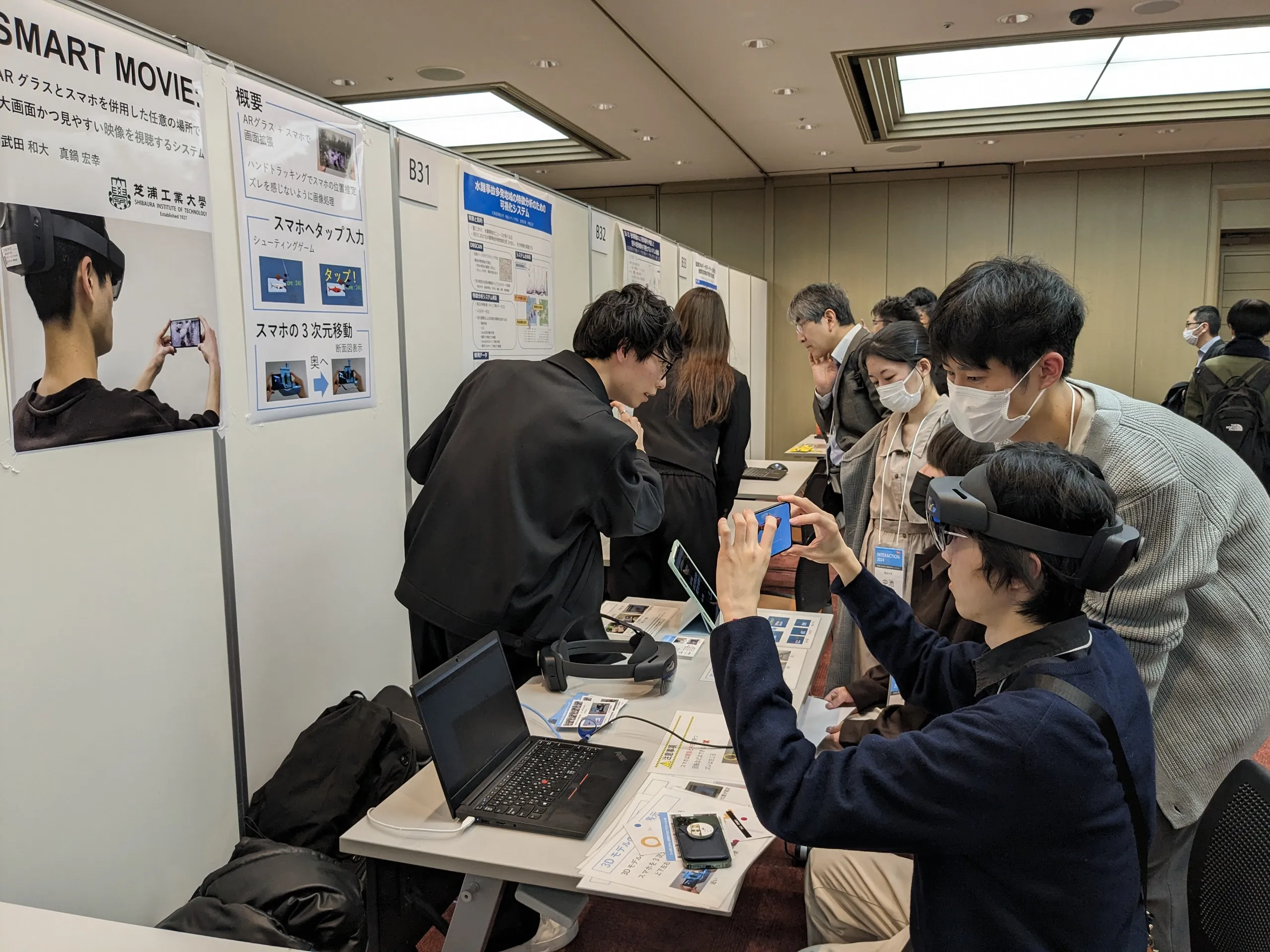

武田です.3月6日~8日に東京都の学術総合センター内一橋記念講堂で開催されたインタラクション2024にM2の阿部広河さんがポスター発表,M1の下田さん,B4の國枝さんと武田がデモ発表を行いました. 発表では,他大学の先生方や企業の方からのアドバイスやコメントを多くいただき,今後の研究に生かしていきたいと思います.自分は学会発表が初めてだったので緊張していましたが,始まると時間があっという間に感じ,楽しかったです.

1日目の発表後には,みんなで会場近くの豚大学で夕食をとりました.多くの学生は「大学院」(1.0kg) を食べ,完食していました.味も美味しく満腹になり,とても楽しかったです.次は「修士」(1.5kg) を食べてみたいと思いました.ご馳走様でした!

研究概要

VRGazeWarp: VRHMDに搭載されたアイトラッカーとVRコントローラを組み合わせたポインティング手法(阿部広河)

アイトラッカーを搭載したVR(Virtual Reality)向けHMD(Head Mounted Display) に対する注目が高まっている.特に,注視箇所周辺の高画質化とシステム負荷の軽減を両立させるFoveatedRenderingという技術が搭載された製品が発表されるなど,アイトラッカーを活用した事例も増えてきている.アイトラッカーは昔から,インタラクション手法への活用が研究されているが,VRHMDに搭載されたアイトラッカーを用いたものに関する研究は,まだ十分に行われているとは言えない.また,アイトラッカーを用いた手法は,ポインタの微調整が難しいという問題が存在する.本研究では,HMDに搭載されたアイトラッカーとVRコントローラを同時に用いたポインティング手法であるVRGazeWarpを提案し,この問題の解決を試みる.実験の結果,性能では提案手法を超えることはできなかったものの,アイトラッカーを用いた手法の,特有の問題に対して対策を行うことで,SUSスコアが向上することが確認できた.

FreelForce: 任意のタイミングで使用可能な非接地型力覚提示デバイス(下田)

仮想空間における力覚提示手法として,糸を用いた非接触型力覚提示デバイスがある.移動しながら使える力覚デバイスとして使用することができるが,手の自由度が制限されてしまうというデメリットが存在する.そこで本研究では,ユーザーが必要としている場面では力覚を体験でき,不要な場面では手が自由になるウェアラブル型の力覚提示デバイス“FreelForce”を提案する.ワイヤの長さが制御可能であるリールストラップをHMD上部に設置しており,ユーザーがワイヤ先端の把持部をつかむことで力覚提示を行う.デバイスの実装と2つのアプリケーションの作成を行い,提案手法の有効性を確認した.

VR環境下における身体背面部へのタップ操作による入力領域拡張(國枝)

現在のVRアプリケーションで利用される操作の一つに,ハンドトラッキングによるジェスチャがあるが,この操作手法にはHMDの内蔵カメラに手が映る範囲でしか利用できない問題や,入力語彙が少ないなどの問題がある.本稿では,これらの問題を解決するため,身体背面部などのあまり利用されていない領域を活用し,身体背面部をVR空間上のUI操作の入力領域として用いる手法を提案した.提案手法の実装を行い,腰や後頭部などの身体背面部へのタップを検出できることを確認した.

SMART MOVIE: ARグラスとスマホを併用した任意の場所で大画面かつ見やすい映像を視聴するシステム(武田)

ARグラスで映像視聴する際,画面の大きさを自由に変更できるが,現実世界が透けて見づらくなる一方,スマホでは画面の大きさがデバイスの大きさに制限される.そのため両者を組み合わせた映像視聴システムが提案されたが,スマホの位置が固定されるという課題がある.そこで本研究では,ARグラスとスマホを併用してスマホを自由に移動できる映像視聴手法を提案する.提案手法の実装を行い,スマホを移動させて映像視聴できたが,遅延や2つの映像のズレが生じるなどの課題があった.